Open AI

Nombre del elemento: Open AI

Categoría: Cognitivo (Cognitive)

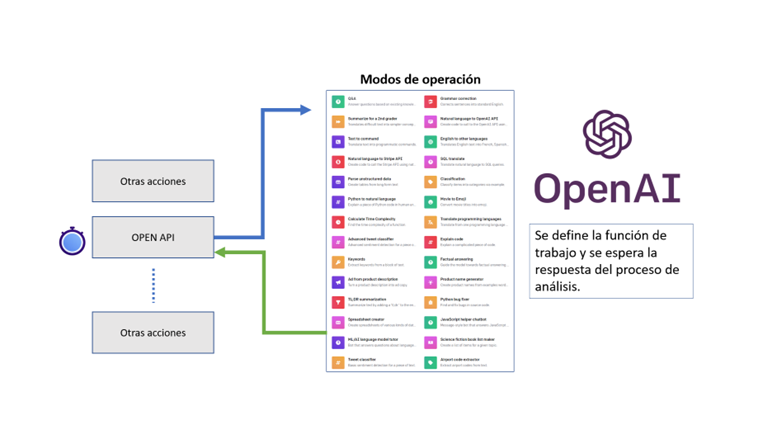

Descripción: Funcionalidad avanzada. Permite la integración con las API de IA agregando la posibilidad de integrar características conversacionales libres y entrenamientos basados en los corpus que ofrece dicha herramienta, incluyendo clasificadores.

Funcionalidad: Se puede aplicar a cualquier funcionalidad ofrecida en la librería de ejemplos de OpenAi. Su principal acción es de interfaz o conector con la API del gestor cognitivo, algunas de las posibilidades son: traducciones, clasificadores, análisis de sentimientos de frases, generador de sarcasmo, generadores de QnA (Preguntas y respuestas), generadores de Listas, análisis de palabras claves, traductor de textos a emojis, interpretes para voz de tercera persona, cuestionarios de entrevista o encuesta.

Nota ❕: para implementaciones orientadas a chat puede ocupar la acción dedicada Chat OPENAI de la librería de acciones de Lynn Diseñador, lo que puede facilitar la experiencia.

Campos de configuración de acción de Open AI

[Nombre]: Descriptor único de caja de configuración con fines de identificar la misma en el flujo.

Subconjunto Configuraciones OPENAI

[El nombre de la entidad obtenido de una expresión]: Expresión o entidad que contendrá el dato a ser evaluado por IA. También es admitido concatenar frases o verbos de acción para concatenar entradas de texto.

-- Ejemplo 1 expresión: 'Translate this into Spanish: '+ OPENAI_INPUT

-- Ejemplo 2 entidad: preguntaOpenAi

Modelo: Expresión de tipo string donde se debe indicar el modelo a utilizar para la validación del texto. Existen modelos con diferentes niveles de capacidades:

-

GPT-3: Conjuntos de modelos que permiten comprender y generar lenguaje natural

-

text-davinci-003: Permite realizar cualquier tarea que puedan realizar los otros modelos de este conjunto, con mayor calidad, duración y mejor seguimiento de instrucciones. (Solicitud máxima de 4000 tokens).

-

text-curie-001: Muy capaz, pero de mayor rapidez y menor costo que Davinci (Solicitud máxima de 2048 tokens).

-

text-babbage-001: Capaz de realizar solicitudes sencillas, muy rápidas y de menor costo (Solicitud máxima de 2048 tokens).

-

text-ada-001: Capaz de realizar tareas muy simples, generalmente el modelo más rápido y el de más bajo costo. (Solicitud máxima de 2048 tokens).

-

-

Codex: Conjuntos de modelos que permiten comprender y generar código, incluyendo la traducción del lenguaje natural a código.

-

code-davinci-002: Modelo más capaz. Particularmente bueno para traducir lenguaje natural a código. Además de completar el código admite la inserción de finalizaciones dentro del código. (Solicitud máxima de 8000 tokens).

-

code-cushman-001: Casi tan capaz como Davinci Codex, pero de mayor rapidez, esta ventaja se puede utilizar para aplicaciones en tiempo real. (Solicitud máxima de 2048 tokens).

-

-

Content Filter: Modelo perfeccionado que permite detectar si el texto puede ser confidencial o seguro.

Nota ❕: consulte los modelos disponibles AQUI.

La expresión se debe insertar entre comillas simples.

-- Ejemplo: ‘text-davinci-003’

[Temperatura] (obligatorio): parámetro tipo float que indicará que el modelo asumirá más riesgos o olguras en la respuesta. Si se inserta el valor de 0.9, se puede utilizar en aplicaciones más creativas y 0 para aquellas que tienen una respuesta bien definida.

El valor 1 corresponde al valor predeterminado.

-- Ejemplo: 0.8

Nota ❕: consulte las sugerencias de temperatura según la función seleccionada OPENAI (ejemplos)

[Top_P] (obligatorio): parámetro tipo Float que considerará el % de las palabras más usadas y las utiliza en la respuesta IA. Es decir, si se inserta el valor de 0.6 corresponderá al 60% de palabras con mayor uso.

-- Ejemplo: 0.6

[Max_Tokens] (obligatorio): Expresión de tipo Integer que corresponde al número máximo de tokens a generar.

Los tokens pueden ser palabras individuales, pero también caracteres, frases u oraciones. Estos son los que permiten entender y generar los textos de respuesta.

Principalmente configurar un mayor valor de token, generará respuestas más complejas, asertivas y de mayor calidad, con la desventaja de que pueden demorar más es ser procesadas y tendrán un coste mayor.

-- Ejemplo:150

[Stop] (opcional): define una cadena de texto que detendrá el proceso de respuesta del motor OPENAI.

-- Ejemplo: STOP <-- f)

-- Entrada a analizar: 'List 10 science fiction books order by a), b), c):'

-- Resultado:

a) Dune by Frank Herbert

b) The Hitchhiker's Guide to the Galaxy by Douglas Adams

c) 1984 by George Orwell

d) The War of the Worlds by H.G. Wells

e) Ender's Game by Orson Scott Card

Nota ❕: Observar que la secuencia se detiene al llegar a f) independientemente de que no se han listado 10 elementos, esto representaría el stop. Usualmente se admiten hasta 4 secuencias. Referencia de ejemplo AQUI

[Autorización]: parámetro tipo clave que permite la configuración de la llave de autorización asociada a una consulta OPENAI API. Para saber cómo gestionar este parámetro y crear sus propias llaves consulte AQUI

[Entidad donde se va a depositar el resultado de la evaluación]: Este campo define el nombre de una entidad que contendrá la salida al análisis de OPENAI, siendo posible su post Procesado.

[Manejador de errores]: Caja de selección donde se identifica la intención que se activara en caso de presentarse un error en la acción OpenAi. Al ejecutarse un desborde de error la entidad OpenAi_Error será cargada con el detalle de error si el mismo se encuentra disponible.